Ahora que estamos en periodo post-vacacional (los afortunados que las han tenido) merece la pena brevemente analizar cómo está este complejo movimiento estratégico y debate legislativo acerca de la regulación de AI.

Hay café para todos, pero descafeinado. Para una tecnología cuyo desarrollo no tiene fronteras, no hay un debate global. Es una carrera de fondo, ningún país se quiere quedar atrás, y se habla mucho del balance entre responsabilidad e innovación, pero aún ningún corredor ve la meta:

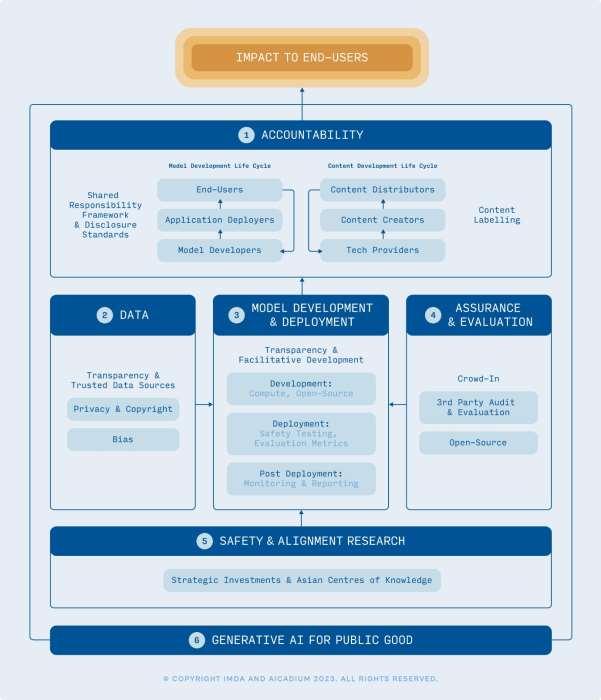

- En Singapur el IMDA y Aicadium han publicado en Junio 23 un discussion paper con una visión acerca de cómo Singapur puede crear un ecosistema que permita el desarrollo de Gen AI “Generative AI: Implications for Trust and Governance”

- En Japón se ha establecido en Mayo 23 el AI Strategy Council, con el objetivo de que los políticos trabajen con asesores que les ayuden a entender cómo definir una estrategia adecuada.

- En UK también en Junio 23 se cerró el periodo de consultas para el White Paper “A pro-innovation approach to AI regulation” publicado en Marzo y que trata de posicionar a UK como una superpotencia en la materia.

- En EEUU, el Senador Josh Hawley anunció en Junio 23 los “Guiding Principles for the Future of American Artificial Intelligence (AI) Legislation” que – entre otras cosas- promueve prohibiciones de importar tecnología relacionada con IA procedente de China, y aboga por prohibir a las empresas estadounidenses que ayuden al desarrollo de la IA en China.

En este contexto, España también tiene su sitio y puja por el liderazgo en Europa. De hecho, el Gobierno ha publicado ya en Agosto el Real Decreto 729/2023, por el que se aprueba el Estatuto de la Agencia Española de Supervisión de Inteligencia Artificial. Con esta norma, España se anticipa y crea la «autoridad nacional de supervisión» que será la encargada de supervisar la aplicación de la futura Ley de Inteligencia Artificial europea (AI Act). Y – claramente marcando distancia con otros países- España ha anunciado que las entidades ya pueden pre-registrar su interés para participar: o bien en el Consejo Asesor de Expertos, o bien en el Sandbox de AI (como proveedor o usuario). Esto será un paso fundamental para operacionalizar los requisitos de la futura regulación en Europa.

Con respecto a esta futura norma, Europa avanza lento pero seguro en disponer de una regulación exhaustiva. En junio, finalmente se adoptó por gran consenso la posición del Parlamento Europeo en la materia. Los responsables políticos celebraron este hito, remarcando que:

- Se ha discutido mucho sobre la necesidad de evitar el riesgo de vigilancia masiva para proteger la Seguridad y confidencialidad de los ciudadanos.

- Se ha mejorado la propuesta de la Comisión en la regulación de AI Generativa, buscando la máxima transparencia. El contenido que sea producido por IA, debe ser reconocible por las personas, para eliminar noticias falsas y discursos de odio que envenenan nuestra democracia.

- Se ha incluido una clara definición de AI, alineada con la definición existente en EEUU, para facilitar convergencia global y alineamiento en el mundo empresarial (en el que ya se respira mucha tensión competitiva entre los grandes “players”).

Ahora el proceso legislativo sigue su curso con negociaciones Parlamento – Consejo. quienes tendrán que acercar posiciones en temas muy importantes como:

- La vigilancia biométrica en espacios públicos, que sigue siendo un punto de desencuentro entre privacidad y seguridad,

- El régimen aplicable a “foundation models”. Se espera que estos modelos respeten unos mínimos estándares y que haya reglas de intercambio de información entre desarrolladores y usuarios. Pero sobre todo, se espera que los desarrolladores establezcan un sistema integral de gestión de riesgos. Estos deberán evaluar los riesgos que su tecnología pudiera tener en un amplio espectro (para la salud, seguridad, derechos fundamentales, medio ambiente, el imperio de la ley y la democracia); y

- La definición de casos que se vayan a considerar sistemas de “alto riesgo”, que serán determinantes para la implantación de las medidas de la norma.

Todos estos temas no dejan de generar cuestiones: Por ejemplo ¿Cómo – en un espectro tan amplio como la salud o la democracia- los sistemas de “general purpose” podrá cumplir con los requerimientos de gestión de riesgos? ¿Y cuál será el coste de este cumplimiento?. Y también han generado denuncias: Se ha llegado a denunciar que la normativa tiene una brecha en su artículo 6 que permitiría a los desarrolladores de sistemas de IA decidir subjetivamente por ellos mismos si sus sistemas son de alto riesgo o no (determinando finalmente si la ley les aplica o no).

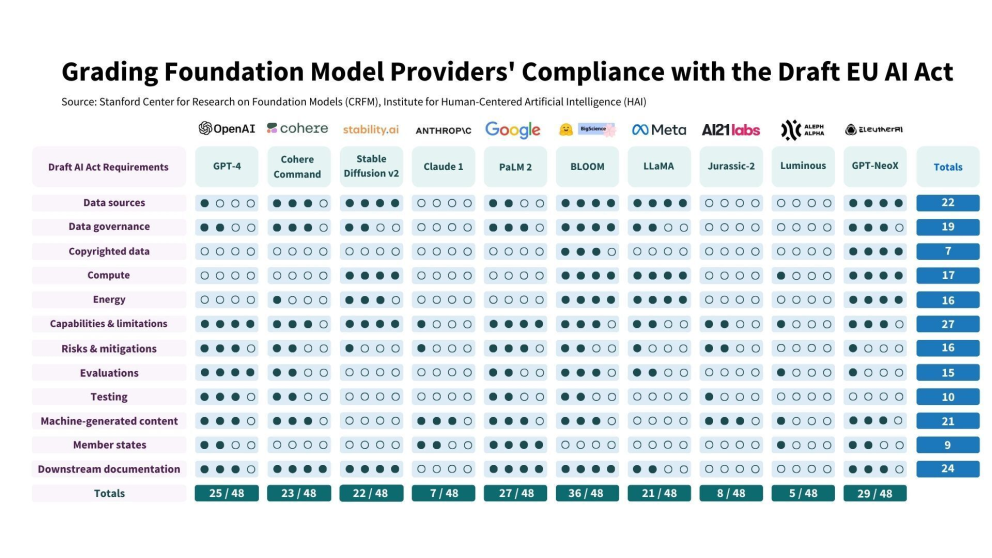

En fin, el reto seguirá siendo encontrar el balance entre seguridad y uso sin restricciones. Por un lado, seguimos escuchando a importantes expertos en la materia alertando acerca de la superinteligencia artificial que supera con creces a la inteligencia biológica (Es interesante escuchar a Geoffrey Hinton en Cambridge CSER “Two Paths to Intelligence”). Pero, por otro lado, el mercado europeo no puede ser tan restrictivo que espante a empresas innovadoras e inversores (y ya escuchamos al CEO de OpenAI sugerir que podría plantearse abandonar la UE). En este sentido Stanford Research ha llegado a publicar un interesante estudio anticipando cómo los grandes competidores en IA se encontrarían con respecto al cumplimiento (o no) con la norma.

Sigamos atentos a todas estas estrategias, debates legislativos y opiniones. Hay mucho negocio en juego, pero también hay mucha necesidad de no olvidar que esta tecnología puede tener un alcance aún desconocido, y que hemos de luchar para que las emociones y juicios propios del ser humano no se vean anuladas por un progreso (el tecnológico).

Bibliografía

- EU AI Watch.

- 771 Amendments adopted by the European Parliament on 14 June 2023 on the proposal for a regulation of the European Parliament and of the Council on laying down harmonised rules on artificial intelligence (Artificial Intelligence Act) and amending certain Union legislative acts (COM(2021)0206 – C9-0146/2021 – 2021/0106(COD)). Texto. Conferencia de prensa.

- Visión comparativa de las posiciones institucionales de las diferentes partes negociadoras (PDF) (Comisión, Parlamento, Consejo).

- Tensión competitiva entre los grandes desarrolladores.

- European Digital Rights (EDRi), Access Now, y otras 115 asociaciones han denunciado una brecha en la AI Act relacionada con la definicion de “alto riesgo” de los sistemas (PDF).

- Estudio “Do Foundation Model Providers Comply with the Draft EU AI Act?”.

- “Generative AI at the CrossRoads”, Oxford Business Law.

- Enlace para seguir el proceso legislativo de la norma,