Introducción

El uso de técnicas de Inteligencia Artificial no es algo nuevo en el mundo industrial. Así, la aplicación de algoritmos de búsqueda local (algoritmos genéticos, beam search, tabu search, …) para resolver problemas de planificación de operaciones (scheduling) o técnicas de regresión para realizar predicciones, ha sido algo habitual desde hace décadas. Pero entonces, nos podríamos preguntar, ¿Qué ha cambiado?, ¿Por qué tanto revuelo con los datos, la analítica, la inteligencia artificial, … y su aplicación en la denominada Industria 4.0?. Han cambiado muchas cosas, pero quizás las principales han sido:

- Concienciación por la importancia de los datos y la analítica sobre ellos: El éxito de los gigantes digitales , con una apuesta radical por los datos y la inteligencia artificial ha conseguido que el mundo industrial tome conciencia de la importancia de los datos y la analítica como factor de competitividad.

- Disponibilidad de datos en formatos digitales: Poco a poco, el mundo industrial, va haciendo desaparecer el papel y esto genera datos en un formato apropiado para su uso en modelos analíticos. Esto ha sido gracias a la integración de sistemas, IoT, herramientas de movilidad etc.

- Inteligencia Artificial: Aparición de nuevos modelos, que comienzan a ofrecer unos resultados de suficiente calidad para su aplicación práctica, en áreas de gran interés para las empresas industriales.

Retos

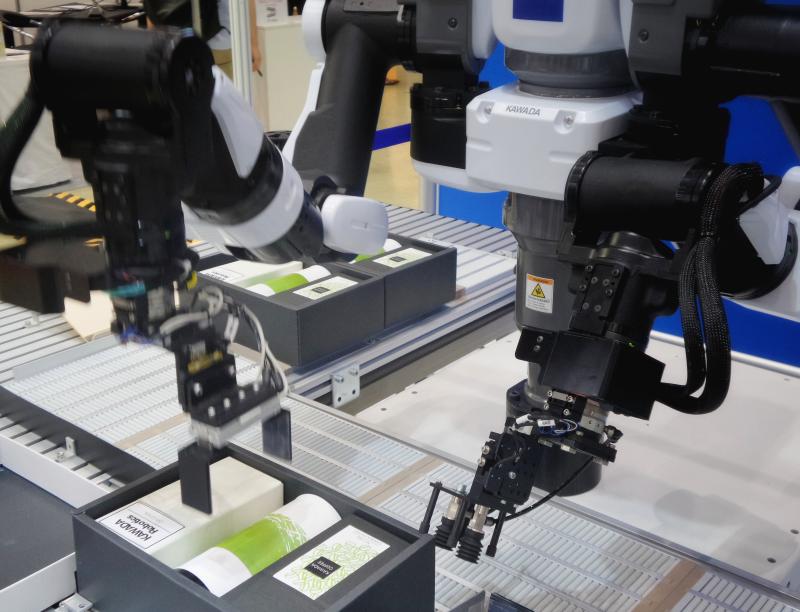

Quizás el mayor reto al que se enfrenta el mundo industrial es la necesidad de poder atender una demanda cada vez más exigente y diversa y al mismo tiempo, ser muy competitivos en precio y plazos. Lo primero requiere capacidades productivas flexibles (ej. posibilidad de producir productos diversos), mientras que lo segundo requiere automatización (ej. producción masiva que abarata precios y plazos). El sistema productivo ideal debería ser automático pero flexible. Pero hasta ahora, la automatización ha implicado falta de flexibilidad (ej. automatizar para producir siempre un mismo producto), mientras que la flexibilidad (ej. producir tiradas bajas de piezas muy diversas) ha requerido un importante esfuerzo manual, ya que los humanos tenemos una capacidad innata para adaptarnos a distintas actividades con muy poco esfuerzo, es decir, somos muy flexibles. Para conseguir reducir el hueco existente entre sistemas productivos muy especializados y poco flexibles, y sistemas productivos muy manuales y flexibles, se requiere que las máquinas comiencen a adquirir algunas de las destrezas que los humanos tenemos. Es decir, que las máquinas comiencen a ser más “inteligentes”, para ello se requerirían capacidades como las siguientes:

- Capacidad de trabajar con datos poco estructurados (imágenes, audio,…).

- Capacidad de aprender rápido nuevas tareas.

- Capacidad de tomar decisiones con información parcial y basadas en la experiencia.

Tendencias

La gran revolución de la inteligencia artificial ha venido de la mano del Aprendizaje Profundo o Deep Learning, gracias a su capacidad de procesar de forma exitosa datos poco estructurados como son imágenes, audio y texto y a su capacidad para abordar tareas complejas sin necesidad de importantes (y costosos) trabajos previos de caracterización del problema (feature engineering). Pero eso ha sido sólo el comienzo, ahora aparecen nuevas técnicas como el Aprendizaje por Refuerzo o Reinforcement Learning basadas en Deep Learning, que abren nuevas oportunidades al mundo industrial.

Para entender mejor lo anterior y ver su posible impacto en un contexto industrial, las técnicas analíticas se suelen dividir en tres tipos[1], atendiendo a su objetivo :

- Analítica descriptiva: Su objetivo es describir relaciones o patrones en datos históricos. Por ejemplo, qué importancia tienen distintas variables (ej. temperatura, viscosidad,…) en los resultados de un proceso (ej. resistencia a la tracción de una pieza).

- Analítica predictiva: Su objetivo es predecir el futuro a partir de los datos históricos. Por ejemplo, predecir la demanda de un determinado SKU (stock keeping unit o referencia) o predecir cuándo un motor va a requerir un cambio de rodamientos.

- Analítica prescriptiva: Su objetivo es recomendar acciones (o decisiones) para alcanzar un objetivo. Por ejemplo, optimizar la planificación de las operaciones de un taller para cumplir con los objetivos de producción sujeta a los recursos disponibles.

Las nuevas técnicas de Inteligencia Artificial han impactado principalmente en la analítica predictiva. Así, las nuevas técnicas de Deep Learning, han supuesto, no sólo una importante mejora en los resultados de los modelos predictivos en términos de precisión, pero, sobre todo, han permitido comenzar a utilizar, con buenos resultados, datos poco estructurados como son imágenes, audio y texto.

Ejemplos

Algunos ejemplos de analítica predictiva en el mundo industrial son:

- Clasificación automática de piezas defectuosas: Modelos predictivos que a partir de la imagen de una pieza determinan si esta es defectuosa o no. Estos modelos son entrenados con conjuntos de piezas defectuosas y no defectuosas y una vez entrenados son capaces de discriminar con éxito cuando una pieza es defectuosa.

- Detección, seguimiento y medición mediante video (visual sensing): Modelos predictivos que detectan si en una imagen procedente de una cámara de video, hay un objeto de interés (ej. una pieza o un operario), la siguen mientras permanece en el foco de la cámara y al mismo tiempo pueden “medir” elementos de interés (ej. contar el número de piezas, clasificar las piezas,…).

- Soft-Models: Modelos predictivos que permiten, en tiempo real, predecir el valor de un parámetro de salida de un proceso/producto (ej. elasticidad final), tomando como entrada datos de distintos sensores (ej. temperatura, consumo de energía, imagen, scanner,…). En muchos casos estos modelos complementan o sustituyen costosos análisis de muestras en laboratorio.

- Detección de eventos anómalos: El objetivo es detectar elementos anómalos o fuera de control. Para ello se compara la variable de interés medida en planta (ej. temperatura de una pieza) con la predicción de un modelo y en caso de discrepancia se genera una alerta. La ventaja de utilizar un modelo de predicción es que este puede incorporar distintos factores (ej. tamaño pieza, material pieza,…) que afectan a la variable de interés consiguiendo una mejor sensibilidad en la detección y reduciendo el número de falsos positivos.

- Mantenimiento predictivo: Los modelos son entrenados para detectar la probabilidad de fallo de un componente (ej. rodamiento de un motor) a partir de determinados datos capturados por sensores (ej. potencia consumida, temperatura, vibración). Una vez entrenados con datos históricos, el modelo manda una alerta cuando un componente tiene una probabilidad alta de fallo.