En la era de la inteligencia artificial (IA), los modelos fundacionales se han erigido en pilares esenciales de las tecnologías más innovadoras. Estos sistemas avanzados, que abarcan desde la traducción automática hasta la creación de imágenes, están impulsando la productividad a niveles sin precedentes. No obstante, su creciente complejidad plantea una cuestión crítica: ¿cómo podemos interpretar y justificar las decisiones que toman? La explicabilidad de la IA (XAI, por sus siglas en inglés) emerge como un área clave para enfrentar este desafío, con el objetivo de hacer que los modelos fundacionales sean más transparentes y, en consecuencia, más responsables y dignos de confianza.

¿Qué es la Explicabilidad de la IA (XAI)?

La XAI se centra en las estrategias y procedimientos diseñados para hacer que las decisiones y operaciones de los sistemas de IA sean inteligibles para los seres humanos. Su propósito es que las personas puedan comprender, confiar y manejar eficazmente la IA. Esto cobra especial relevancia en sistemas que efectúan juicios complejos, como aquellos empleados en campos como la medicina, la seguridad y las finanzas, donde es vital entender el razonamiento de la IA para su integración y control efectivos. La XAI se esfuerza por esclarecer interrogantes tales como:

- ¿Cuál fue el motivo detrás de esta decisión de la IA?

- ¿Qué información tuvo mayor impacto en esa elección?

- ¿De qué manera variaría la decisión si los datos iniciales fuesen distintos?

Ejemplos de Aplicación de la XAI

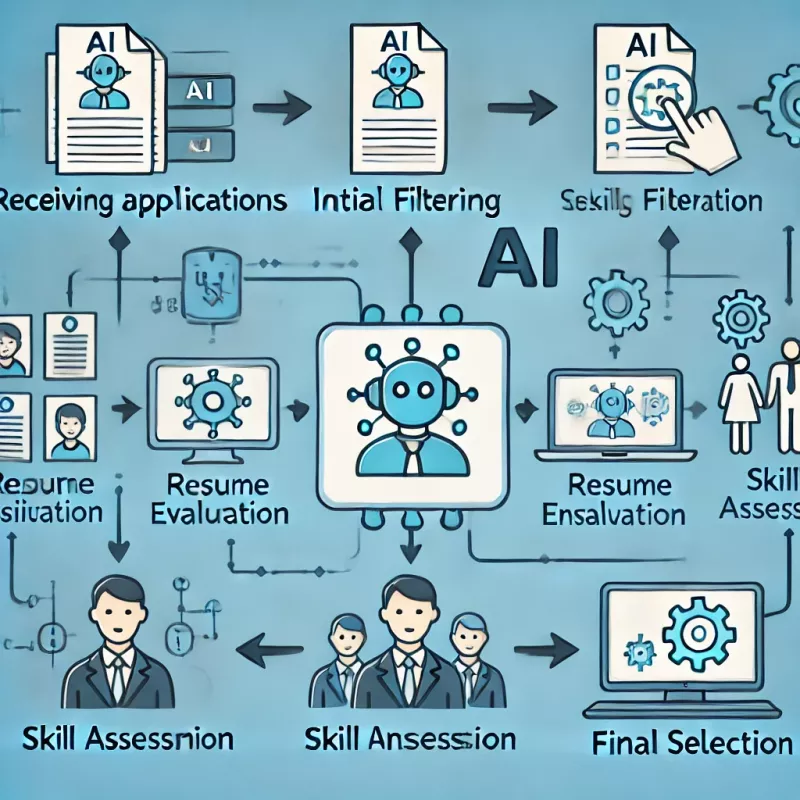

- Selección de Personal: En entornos donde algoritmos seleccionan o filtran currículums, la XAI puede clarificar las razones detrás de las elecciones realizadas, lo cual es fundamental para identificar y rectificar prejuicios. Por ejemplo, una compañía tecnológica descubrió mediante XAI que su algoritmo prefería candidatos de ciertas universidades, lo que motivó una revisión de su proceso de contratación.

- Diagnósticos Médicos: En sistemas de IA que asisten en diagnósticos clínicos, la explicabilidad es crucial para que los profesionales médicos entiendan las recomendaciones del sistema, lo que fomenta la confianza y la adopción de estas herramientas. Un centro hospitalario en Europa empleó XAI para determinar las variables que un modelo de IA usaba para prever la sepsis, optimizando así la comunicación entre doctores y pacientes.

- Vehículos Autónomos: Para los coches autónomos, comprender las decisiones de la IA es vital para la seguridad. Si un automóvil ejecuta una maniobra inesperada, los ingenieros deben ser capaces de examinar y justificar el comportamiento para perfeccionar los algoritmos y asegurar la seguridad pública. Tras un incidente con un vehículo autónomo, la XAI permitió a los expertos ajustar el modelo para mejorar la anticipación de obstáculos en circunstancias similares.

¿Qué son los Modelos Fundacionales?

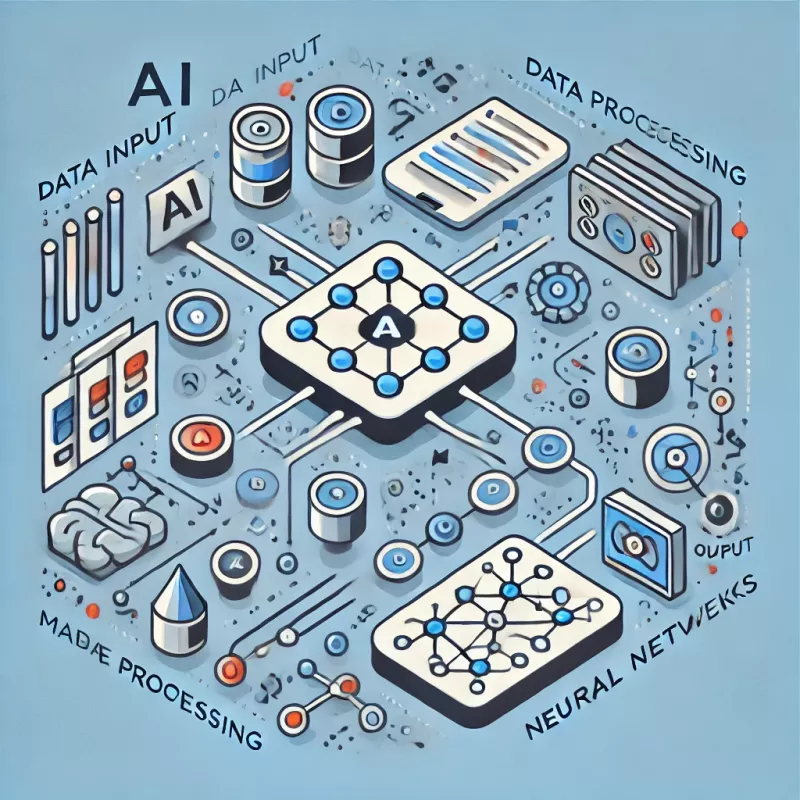

Los modelos fundacionales son estructuras de IA a gran escala que se han entrenado con enormes cantidades de datos para llevar a cabo un amplio espectro de tareas de IA. Estos modelos constituyen la base sobre la que se edifican aplicaciones más específicas y avanzadas. Por ejemplo, un modelo entrenado en diversos idiomas puede no solo traducir entre ellos, sino también generar resúmenes, contestar preguntas y crear nuevo contenido en dichas lenguas.

La característica principal de los modelos fundacionales es su habilidad para aprender representaciones generales a partir de los datos con los que se entrenan. Esto les permite aplicar su aprendizaje a una variedad de problemas distintos, otorgándoles una versatilidad y potencia extraordinarias. Sin embargo, esta misma complejidad y amplitud son las que presentan desafíos para comprender cómo llegan a conclusiones específicas, subrayando la importancia de la XAI.

Técnicas Específicas de XAI en Modelos Fundacionales

El campo de la XAI aún se encuentra en sus primeras etapas, especialmente en lo que respecta a los modelos fundacionales. Sin embargo, se han desarrollado diversos métodos y técnicas para abordar este desafío. Algunas de ellas son las siguientes:

- Métodos basados en la interpretación:

- Local Interpretable Model-Agnostic Explanations (LIME): Esta técnica genera explicaciones locales, es decir, para una predicción específica, identificando las regiones del espacio de entrada que más contribuyen a la decisión del modelo.

- Shapley Additive exPlanations (SHAP): Esta técnica asigna valores de importancia a cada característica del modelo, lo que permite comprender su contribución individual a la predicción.

- Grad-CAM: Esta técnica visualiza las regiones de una imagen que más influyen en la predicción de un modelo de visión artificial.

- Métodos basados en la simulación:

- Contrastive Explanations: Esta técnica genera explicaciones contrastivas, es decir, ejemplos que son similares al punto de datos de entrada pero que conducen a una predicción diferente. Esto puede ayudar a comprender qué aspectos del punto de datos de entrada son más importantes para la decisión del modelo.

- Input-Gradient: Esta técnica modifica iterativamente el punto de datos de entrada para observar cómo cambia la predicción del modelo. Esto puede ayudar a identificar las características más importantes para la decisión del modelo.

Desafíos y Consideraciones de la XAI

A pesar de sus ventajas, la XAI enfrenta retos significativos. La complejidad de los modelos fundacionales, con billones de parámetros, convierte la explicación de sus decisiones en una tarea compleja. Además, hay riesgo de que las explicaciones sean manipuladas o malinterpretadas, lo que podría mermar la confianza en los sistemas de IA.

El desarrollo de técnicas de XAI también conlleva un coste considerable. No obstante, estos gastos deberían equilibrarse con los beneficios a largo plazo de una IA más transparente y fiable. Las inversiones en XAI pueden llevar a una mayor aceptación y confianza en la IA, así como a la prevención de errores costosos y daños a la reputación.